La mise en place d’une réglementation s’appuie avant tout sur des études acceptées par tous. Pour qu’il y ait réglementation, il faut d’abord qu’il y ait consensus autour des productions académiques. En effet, ces dernières permettent de révéler l’impact du trading à haute fréquence sur la qualité des marchés. D’après le chercheur Marc Lenglet, la qualité de marché regroupe de nombreuses notions telles que la liquidité, la volatilité, les coûts de transaction et l’efficience des marchés. A partir de ces résultats, les institutions régulatrices peuvent trancher sur la nécessité d’un encadrement et sur la nature de ce dernier.

Un représentant de l’AMF explique que l’appréciation correcte des enjeux liés au THF est primordiale. Elle permet d’envisager des réponses réglementaires cohérentes au bon fonctionnement des marchés.

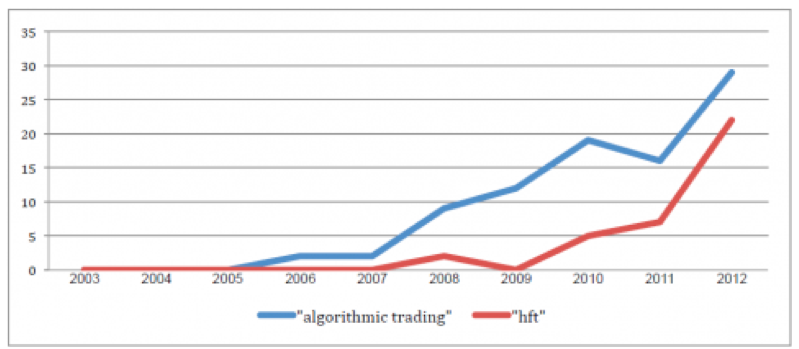

Le Trading à Haute fréquence est une pratique étudiée depuis peu. Si son étude s’est largement développée ces cinq dernières années, le nombre de papiers publié reste faible:

Nombre de working papers relatifs au trading algorithmique (requête sur « algorithmic trading ») et au trading haute fréquence (requête sur « hft ») mis en ligne sur le site http://www.ssrn.com/ , sur une période de dix années.

Or il n’existe pas de réel consensus sur l’influence réelle du HFT sur les marchés.

Le rapport de l’AMF « Quels risques financiers macroéconomiques pour l’année 2014 » insiste sur la pluralités des conclusions académiques :

« C’est dire aussi que l’étude de cette activité reste encore hésitante et partagée quant aux bénéfices du THF : les études empiriques ne sont pas unanimes pour en montrer un gain net évident pour la liquidité des marchés ou le financement de l’économie. »

Pour comprendre la divergence des résultats publiés, il s’agit de s’interroger sur la collecte et la gestion des données utilisées.

Durant toute cette partie, nous élargirons nos recherches au monde entier. Les politiques Européennes ne s’appuient pas uniquement sur les papiers scientifiques Européens. Le débat scientifique ne peut pas être limité géographiquement. Ainsi, il faut prendre en compte toute l’étendue des publications pour comprendre l’enjeu du problème.

La difficile définition du HFT

La définition du THF n’est pas tranchée. Cette pratique est plurielle : Les acteurs sont différents et leur impact sur les marchés financiers sont divergents. L’enjeu est en effet de séparer les pratiques algorithmiques de haute fréquence et le trading plus « traditionnel ».

Dès lors le choix d’une définition du THF plutôt qu’une autre influence les résultats d’une étude. A cet égard l’AMF affirme que :

« Le premier défi dans l’étude des risques posés par le HFT est celui de sa définition, qui en conditionne ensuite largement la place. »

Quelles définitions du HFT faut-il retenir ?

D’après le rapport de l’AMF», plusieurs définitions sont retenues par différentes institutions.

- Les autorités européennes (telles que l’ESMA) s’appuient sur l’interprétation des signaux de marché par des technologies sophistiquées qui génèrent des offres à haute fréquence pour compte propre.

- Les autorités Etats-uniennes (SEC, CFTC) complètent la définition en ajoutant que la plupart de ces ordres sont annulés peu de temps avant leur envoi. Ils évoquent également le phénomène de colocation d’alimentation en données de marché pour minimiser la latence.

- La littérature scientifique retient notre attention lorsqu’il s’agit de définir le THF. Il existe deux manières de concevoir ce dernier : un approche relativement directe qui étudie les acteurs du HFT (tel que le fait Brogaard ) et une approche indirecte (Tel que le fait Jovanovic) qui étudie les volumes des ordres envoyés et le nombre de positions ouvertes en fin de journée.

Ainsi, les acteurs ne définissent pas le Trading à Haute fréquence de la même manière. Dans ces circonstances, il est difficile de comparer et de mettre en opposition des études qui n’ont pas la même base de définition. Cependant, il ne s’agit pas non plus d’homogénéiser des groupes d’acteurs en fonction de la définition qu’ils donnent. Par exemple, au sein même de la littérature scientifique, on ne trouve pas de consensus sur la question de la définition.

La difficile collecte des données…

Au problème de définition s’ajoute celui de la collecte des données. Il existe des obstacles matériels à la constitution de bases de données complètes. La fragmentation des marchés sur différentes plateformes financières rend difficile la formation d’une base de donnée commune. Comme il a été expliqué, la MIF 1 a rendu l’information opaque pour tous les acteurs financiers. Or la caractéristique du THF est de pouvoir réunir ces informations disséminées. C’est donc avant tout le secteur privé du THF qui est capable de fournir ces données. Eun Jung Lee affirme dans son étude « High Frequency Trading in the Korean Index Futures Market »:

« Current estimates of HFT are provided by the private sector through surveys and by a handful of academic studies. »

Pourtant, le secteur privé n’est pas enthousiaste à donner des informations aux autorités financières. Le partage de ces informations est un enjeu pour ces organisations privées, qui veulent avant tout protéger leurs intérêts. De plus, la « culture du secret », comme l’appelle J. El Gharib ne pousse pas les HFTers à partager leurs informations. Le THF est un sujet « tabou », nous affirme un consultant de la Société Générale:

« Personne ne parle de ces pratiques alors que tout le monde est au courant qu'elles se déroulent. »

C’est cette culture du secret et de la protection des intérêts qui entrave la collecte des données.

… qui rend difficile l’étude du Trading Haute Fréquence

Sans données, il est impossible de différencier les pratiques THF et non THF. A cet égard le rapport de la SEC « Equity Market Structure » affirme :

" A summary of the economic literature must begin by highlighting a formidable challenge facing any researcher of HFT – obtaining useful data that can identify HFT activity. Publicly available data on orders and trades does not reveal the identity of buyers and sellers. As a result, it is impossible to identify orders and trades as originating from an HFT account when relying solely on publicly available information. "

Un des problèmes est alors de différencier précisément les acteurs et les pratiques. Le rapport de la SEC poursuit :

" As a result, it is impossible to identify orders and trades as originating from an HFT account when relying solely on publicly available information."

Ce problème de la collecte des données complexifie la production d’études complètes, capables de mettre à jour les problématiques du HFT. E.J. Lee poursuit dans « High Frequency Trading in the Korean Index Futures Market » :

" This lack of precise data on trades and orders complicates the markets authority‟s task in identifying and addressing issues raised by HFT."

De plus, la précarité des données à disposition entraîne des difficultés méthodologiques pour étudier le THF: Pour pouvoir qualifier les enjeux liés à l’adoption du trading à haute fréquence, les chercheurs devraient s’appuyer sur de nombreuses caractéristiques de la pratique: acteurs, marchés, comportements en situation, technique d’algo-trading… Du fait du manque de données à disposition, ils érigent des modèles d’étude incomplets.

Marc Lenglet dans « Les conséquences inattendues de la régulation financière: pourquoi les algorithmes génèrent-ils de nouveaux risques sur les marchés financiers? » explique qu’avec la fragmentation des marchés, les recherches sont souvent restreintes à un seul marché. La mesure des pratiques est dès lors approximée, et les résultats généralisés. A cet égard, les plateformes de marché financier possèdent des caractéristiques différentes. Il s’agit dès lors d’être prudent sur les résultats avancés, qui sont avant tout tributaires d’un contexte particulier.

Lee affirme dans son papier académique « High Frequency Trading in the Korean Index Futures Market »:

" Due to the formidable data challenges facing researchers, the papers included in this literature review examine only a relatively small amount of HFT activity. The HFT Datasets generally have been limited to particular products or markets, and the data time periods now are relatively outdated, particularly given the pace of change in trading technology and practices."

Ce phénomène est connu par tous les acteurs. Il devient un enjeu lorsque les résultats d’une étude sont remis en question au nom d’une carence de données. En effet, il est possible de démontrer des arguments en sélectionnant des données précises.

Ce serait dès lors dire qu’avec un même méthode, mais des données différentes, on peut arriver à des conclusions divergentes sur le THF !

Prenons un exemple :

Dans leurs études de 2011, Hendershott et Riordan affirment que le HFT contribue de manière positive à la découverte des prix. En 2013, Lee publie « High Frequency Trading in the Korean Index Futures Market « dans lequel il reprend la précédente étude. Il étudie la même question et applique la même méthode que Hendershott et Riordan.

Alors que ces derniers c’étaient appuyés sur le Nasquad, Lee sélectionne les données du KOSPI 200 index futures market (une plateforme de marché Coréenne). Ce sont donc deux plateformes différentes qui sont étudiées.

" As another interesting research question, we examine the role of HFT in price discovery in the KOSPI 200 index futures market. We make use of the state space model from Hendershott and Riordan (2011) to determine whether HFT contributes to the price formation process."

Finalement, Lee aboutit à des conclusions opposées de celles de Hendershott et Riordan. Contrairement à eux, il affirme que le HFT agit de manière négative sur le HFT.

" When we decompose futures price into a permanent and a transitory component (Menkveld, Koopman, and Lucas, 2007), we find no evidence that overall HFT increases price discovery and efficiency, inconsistent with the findings from prior research on price discovery of HFTs in stock markets "

Ainsi, à partir des données différentes, il est possible d’aboutir à des conclusions opposées. La gestion des données permet dès lors de manipuler les recherches : il est possible pour un chercheur de démontrer une idée en sélectionnant des données précises. Dès lors la littérature académique devient un outil manipulable pour les différents acteurs de la controverse. Dans la mesure où la littérature scientifique possède une légitimité, il est désormais possible d’étayer ou de rejeter un argumentaire très facilement.

Conséquences au sein des acteurs de la controverse

La polémique prend de l’ampleur lorsque la presse et les lobbys s’emparent de la question pour discréditer une littérature scientifique qui défend une position (et derrière des acteurs précis qui défendent cette position).

Cette idée peu être illustrée par la récente polémique sur le rapport publiée par la BCE en décembre 2013. Ce dernier, intitulé « High Frequency and price discovery » (co-rédigé par Broogard, Hendershott et Riordan) conclut que le THF apporte une haute demande et offre en liquidité. Dès lors elle agit en sens inverse des erreurs d’estimation pour permettre la formation juste des prix. Ces conclusions représentent d’importants arguments pour la production d’une réglementation plus souple.

En réaction à cette publication, le journal Le monde affirme que ces conclusions sont erronées dans la mesure où la base de données sélectionnées est trop réduite. Dans l’article « La BCE utilisée pour donner du crédit au Trading haute Fréquence », Mathilde Damgé affirme que l’échantillon retenu exclut non seulement les « géants bancaires » mais aussi tout les échanges en dehors de la plateforme du Nasquad.

Il faut remarquer que pour donner du poids à ses arguments, M. Damgé s’appuie sur le blog Themis Trading, un groupe de borkers traditionnels (non THF), connus pour leurs prises de position tranchées contre le THF. A propos de la publication de la BCE, le site écrit :

" 1- The study only includes a sub-set of HFT firms. Excluded from their study are “those that also act as brokers for customers and engage in proprietary lower- frequency trading strategies, e.g., Goldman Sachs, Morgan Stanley, and other large integrated firms. HFTs who route their orders through these large integrated firms cannot be clearly identified so they are also excluded.”

2- Only trades that were executed on NASDAQ are analyzed. The authors state that “The data used in the study are from 2008-09 for 120 stocks traded on NASDAQ.” Since NASDAQ market share ranged from 20-30% during the sample data set period, this means that 70-80% of trades were excluded from this study.

3- The authors relied on NASDAQ’s subjective determination of which firms were considered HFT. The authors state “Firms are categorized as HFT based on NASDAQ’s knowledge of their customers and analysis of firms’ trading such as how often their net trading in a day crosses zero, their order duration, and their order to trade ratio.”

4- The authors use only a subset of volume to calculate limit order book imbalances. The paper states, “To test the hypothesis that HFTs use order book information to predict short- term subsequent price movements we calculate limit order book imbalances (LOBI) using the NBBO TAQ best bid and best offer size.” According to Eric Hunsader from Nanex, “The NBBO TAQ file only shows the size at the exchange listed as the best bid or offer. It does not show the aggregate sizes.” Therefore, any analysis of short term direction only using this subset of data is seriously flawed."

Ainsi, le problème de la collecte et de la gestion des données est au cœur de la controverse. Elle rend difficile la formation d’une littérature académique « solide », qui permette aux autorités de saisir les impacts du THF sur le marché. Ce qui en conséquence empêche de mettre en place une régulation exhaustive et adaptée.

Les autorités financières sont conscientes du problème que pose cette carence de données à disposition. Dans son dernier rapport « Quels risques macrofinanciers pour 2014 ? », l’AMF donne des directives pour pallier à ce problème : les autorités doivent pouvoir accéder à « une masse considérable de données », provenant de tous les marchés existants. Le traitement et l’exploitation de ces données doivent devenir plus efficaces. A cet égard la mise en place du LEI (Legal Entity Identifier) doit permettre d’utiliser plus facilement les données disponibles en identifiant rapidement les sociétés.

Il faut observer que si l’AMF est consciente du problème et de ses enjeux, elle ne propose pas de solution concrète pour accéder aux informations plus facilement. L’enjeu est ici bien matériel.